Cómo Integré IA en un Workflow de Análisis de Datos

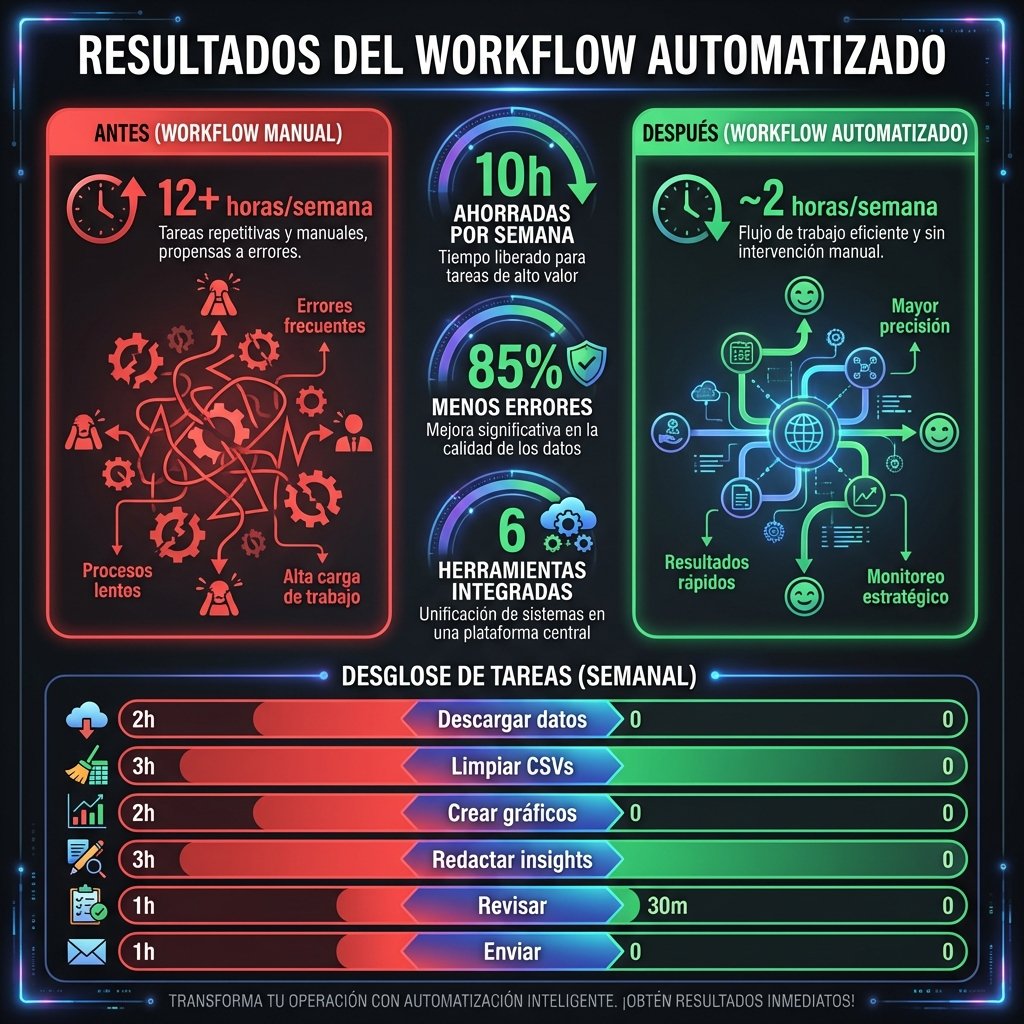

Hace 6 meses, mi proceso de análisis de datos era un desastre manual. Cada informe semanal me llevaba casi un día completo: descargar datos, limpiar CSVs, crear gráficos, redactar insights... Hoy, ese mismo proceso toma menos de 2 horas. Esta es la historia exacta de cómo lo logré.

😤 El Problema: Mi Proceso Anterior

Cada lunes, mi rutina era la misma pesadilla:

- ❌ Descargar 5 CSVs de diferentes plataformas manualmente

- ❌ Limpiar datos en Excel (formatos, duplicados, errores)

- ❌ Crear pivot tables para cada métrica

- ❌ Copiar datos a PowerPoint/Google Slides

- ❌ Escribir insights manualmente

- ❌ Revisar errores de copia-pega

- ❌ Formatear presentación

- ✅ APIs conectadas → datos automáticos

- ✅ Python limpia y transforma

- ✅ Dashboard en Looker actualizado

- ✅ IA genera borrador de insights

- ✅ Yo reviso y ajusto (30 min)

- ✅ Envío automático programado

- ✅ Alertas si algo está fuera de rango

Un cliente de ecommerce recibía reportes cada lunes. Pasaba de enviarlos a las 6pm (después de trabajar todo el día) a tenerlos listos a las 9am con mi única tarea siendo la revisión final de 30 minutos.

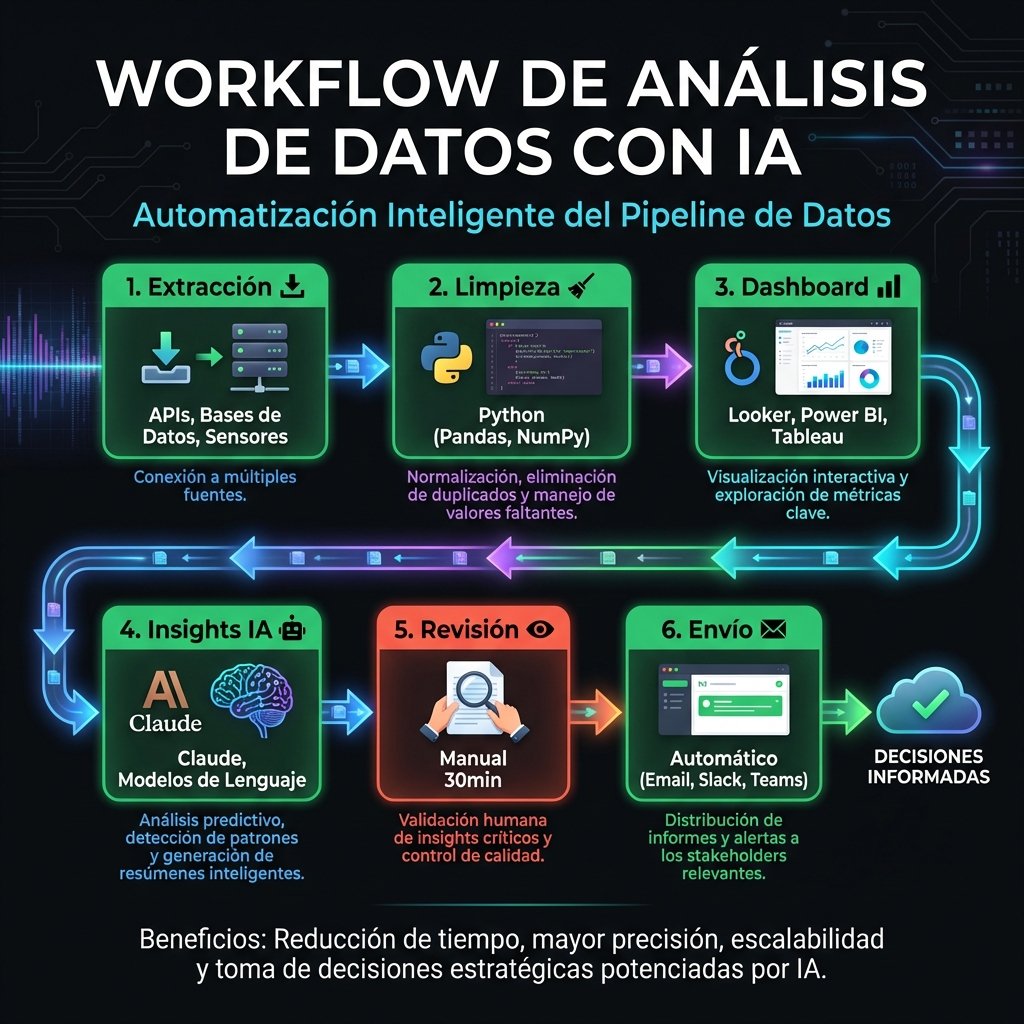

🔄 El Nuevo Workflow Completo

Este es el flujo exacto que uso cada semana. Las tareas en verde las hace la IA automáticamente, las de rojo siguen siendo manuales pero más rápidas:

📊 Mi workflow de análisis de datos automatizado

🛠️ Herramientas que Uso

🔧 Cómo lo Implementé (Paso a Paso)

No lo hice todo de una vez. Fue un proceso de 3 meses, automatizando una pieza a la vez:

Conecté las 5 fuentes de datos principales: GA4, Google Ads, Meta Ads, Shopify y Mailchimp. Usé las librerías oficiales de Python.

# Ejemplo: Extracción de GA4

from google.analytics.data_v1beta import BetaAnalyticsDataClient

client = BetaAnalyticsDataClient()

response = client.run_report(

property="properties/123456",

date_ranges=[{"start_date": "7daysAgo", "end_date": "today"}],

metrics=[{"name": "sessions"}, {"name": "conversions"}]

)

Creé funciones reutilizables para: eliminar duplicados, estandarizar formatos de fecha, calcular variaciones WoW y MoM, y detectar valores atípicos.

Looker Studio conectado a BigQuery para visualización. Claude API para generar el borrador de insights con este prompt:

# Mi prompt para generar insights

Contexto: Dashboard semanal para {cliente}, ecommerce de {categoría}

Datos de esta semana:

{datos_json}

Genera un resumen ejecutivo de 5-7 bullet points que:

1. Destaque los cambios más significativos (+/-10%)

2. Identifique posibles causas (basándote en contexto)

3. Proponga 2-3 acciones concretas

4. Use tono profesional pero accesible

5. Incluya emojis relevantes para facilitar escaneo

n8n conecta todo: ejecuta el pipeline cada domingo a las 23:00, genera el reporte, y si detecta anomalías (caída >20% en conversiones, por ejemplo), me envía alerta por Slack antes de que salga el reporte.

📅 Las 4 fases de implementación del workflow

📈 Resultados y Métricas

Además del tiempo, la consistencia mejoró dramáticamente. Ya no hay errores de copia-pega, los cálculos siempre son correctos, y el formato es idéntico cada semana. Los clientes notan la profesionalidad.

📊 El impacto real del workflow automatizado

Este workflow requirió ~28 horas de setup durante 7 semanas. El ROI se alcanzó en menos de 3 semanas de uso. Pero si no tienes conocimientos básicos de Python o APIs, la curva de aprendizaje es mucho mayor.

Puedo diseñar e implementar un workflow personalizado para tu negocio. Desde dashboards hasta reportes automáticos con insights de IA.

Solicita una consulta →